أخلاقيات الآلة.. السيارة القاتلة!

المعلوماتية >>>> الذكاء الصنعي

صمَّمَ باحثون في مختبرِ MIT Media Lab تجربةً تسمى "آلة الأخلاق MORAL MACHINE" في عام 2014، وكانت غايةُ التجربة إنشاءَ منصّة شبيهة باللعبة من شأنِها أن تجمع القراراتِ التي يمكن أن يتَّخذها الناس عن كيفيةِ إعطاء السيارات ذاتية القيادة الأولويةَ في الحياة لِمن يعترض طريقّهم في أثناءِ العمل، وقد درست التجربة احتمالاتٍ مختلفة ووجهاتِ نظر متعددة لمعضلة (ترولي) الفلسفية أو ما يمكن تسميتها (مسألةَ العربة)، وكان من المتوقَّع أن توفِّر بيانات تلك العملية رؤيةً ثاقبةً عن الأولويات الأخلاقية الجماعية من منظورِ ثقافات مختلفة.

لم يتنبَّأ الباحثون آنذاك بالاستقبال الجماهيري الكبير لتجربتِهم، فبعد مرور أربع سنوات على إطلاقِ المنصّة؛ سجّل ملايين الأشخاص من (233 بلد وإقليم) 40 مليون قرار؛ ممَّا جعلها واحدةً من أكبرِ الدراسات التي أُجريت على الأولويات الأخلاقية العالمية.

وتُقدِّم ورقة جديدة نُشرت في مجلةِ Nature تحليلًا لبياناتِ تلك التجربة، وتكشف مدى اختلاف الأخلاقيات بين الثقافات على أساسِ الثقافة والاقتصاد والموقع الجغرافي.

تفترض مسألة العربة الكلاسيكية أنَّك تشاهد عربةً متحرّكةً تتابع طريقَها في إحدى السكك، ولكنَّها على وشكِ أن تضرب خمسةَ أشخاص وتقتلهم، ولا يوجد بين يديك الآن سوى رافعة لتغييرِ المسارات؛ إذا رفعتها سيتغيَّر سير العربة نحو سكَّة أخرى وتنقذ الأشخاصَ الخمسة، ولكنك ستقتل شخصًا آخر يمشي على تلك السكّة.. فماذا تختار؟!

اعتمدت تجربة آلة الأخلاق في طيّاتِها على مسألةِ العربة تلك لاختبارِ تسع مقارنات مختلفة يمكن عن طريقِها تبيان استقطاب الناس، ونصَّت تلك المقارنات على ما يأتي:

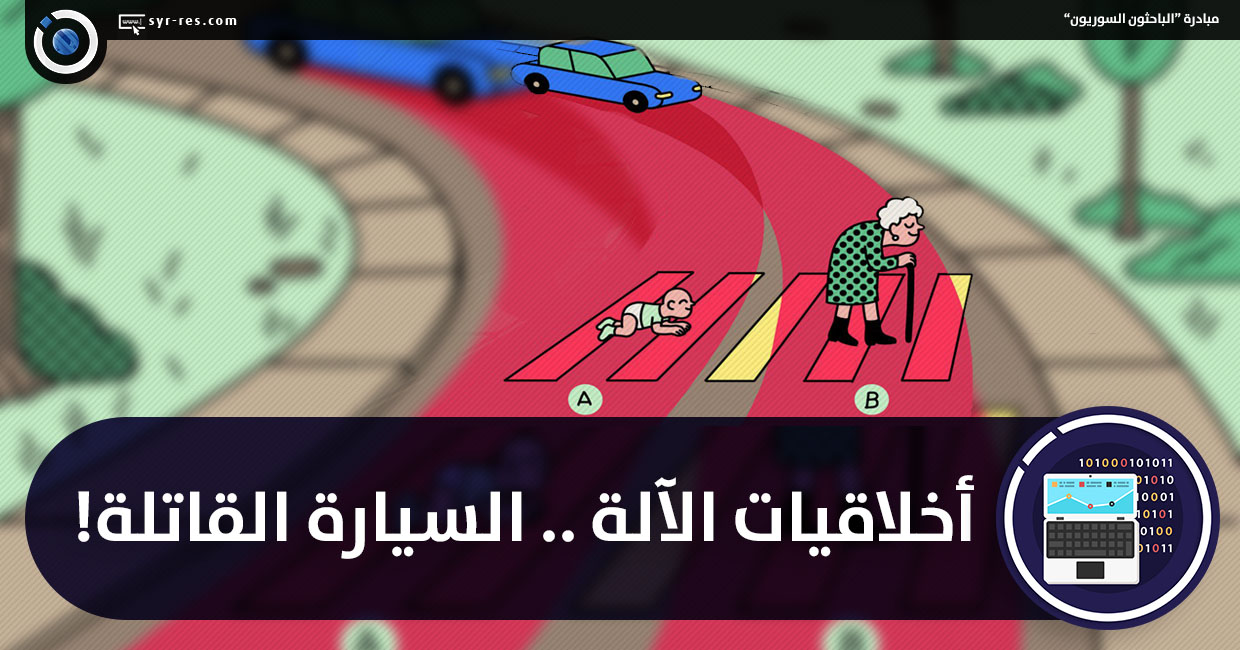

هل يجب على السيارة ذاتية القيادة أن تعطي أولويةَ الحياة للبشر أكثر من الحيوانات الأليفة.. للركّاب مقابل المشاة.. للعدد الكبير من الأرواح أمام العدد الأقل.. للنساء مقابل الرجال.. للشباب أمام الكبار.. لِمَن يمتلكون حالةً صحيةً خاصة.. لمَن لديهم مرتبةٌ اجتماعية أعلى.. للملتزمين بتنفيذِ القانون مقابل المخالفين له..؟! وأخيرًا، هل يجب أن تنحرف السيارة (تتّخذ إجراءات) أم تبقى على المسار نفسِه (التقاعس)؟

Image: https://cdn.technologyreview.com/i/images/scenario1_0.png?sw=600&cx=93&cy=0&cw=657&ch=596

وأحد الأسئلة التي طُرحت على المشاركين في تجربةِ آلة الأخلاق: برأيكَ؛ ماذا يجب على السيارة ذاتية القيادة أن تفعل عندما تكون في الحالة المبيّنة في الصورة؟

ارتكزت تجربة آلة الأخلاق على طرحِ أسئلة وفق نماذج وأشكال عدّة؛ مثل هل ينبغي أن تستمرّ سيارة ذاتية القيادة بالسير في طريقِها لقتلِ ثلاثة من كبارِ السن من المشاة أم تنحرف إلى طريق آخر فتقتل ثلاثةً من الشبّان!. ووجد الباحثون في أثناءِ متابعة دراستهم أنَّ أولويات البلدان وتفضيلاتها تختلف اختلافًا كبيرًا؛ إذ إنَّها ترتبط ارتباطًا وثيقًا بثقافةِ البلد واقتصاده، فقد تبيَّن أنَّ المشاركين المنحدرين من ثقافات ترتكز على روحِ الجماعة -مثل الصين واليابان- كانوا أقلَّ تأييدًا لتجنيبِ الشبَّان من الوقوع في الحادث مقابل تجنيب كبار السن.

ويفترض الباحثون أنَّ ذلك يعود إلى أخلاقيةِ احترام كبار السن في ثقافاتِهم، وبالمقابل؛ فإنَّ البلدان ذات الثقافات الفردية من المرجَّح أنَّها تجنِّب الشبّانَ الوقوعَ في الحادث، وأظهرت النتائج أيضًا أنَّ المشاركين من البلدان ذات الثقافات الفردية -مثل المملكة المتحدة والولايات المتحدة- يركِّزون تركيزًا أكبر على توفيرِ مزيد من الأرواح في ضوءِ الخيارات الأخرى، ويعود ذلك -ربّما- إلى التركيز لديهم على قيمة كلِّ فرد.

إنّ لهذه الدراسة أهميةً كبيرةً لدى البلدان التي تختبر حاليًّا السيارات ذاتية القيادة؛ نظرًا لأنَّ الأولويات والتفضيلات الأخلاقية المستنتَجة يمكنها أن تؤدِّي دورًا كبيرًا في تصميمِ المركبات وتنظيمها.

على سبيل المثال؛ قد يجد صانعو السيارات أنَّ المستهلكين الصينيين يميلون إلى شراءِ سيارة تحمي نفسَها على نحو أكبر من حمايتِها للمشاة.

وقد شدَّد واضعو الدراسة على أنَّ النتائج لا تهدف إلى إملاءِ الكيفية التي يجب أن تتصرَّف بها الدولُ المختلفة؛ إذ يعتقد مؤلِّفو الدراسة أنَّه في بعضِ الحالات يجب على التقنيين وصانعي القرار تجاوزُ الرأي العام الجماعي، وقد طرح إدموند عوض Edmond Awad -مؤلِّف الورقة العلمية للدراسة- مقارنةَ الوضع الاجتماعي بوصفِها مثال؛ فقال: يبدو أنَّ الناس وجدوا أنَّه من الجيِّد -على نحو كبير- أن يفضِّلوا تجنيبَ الأشخاص ذوي المكانة العالية مقابل الآخرين ذوي المستوى الأدنى، فمن المهمِّ لدينا أن نقول: مهلًا؛ يمكننا أن نحدِّد ذلك وندرسه بدلًا من القول إنِّه يجب علينا استخدام ما أملاه الجمهور علينا..

وقال: يمكن استخدام النتائج من قبل الصناعة والحكومة بوصفِها أساسًا لفهمِ كيفية تفاعل الجمهور مع أخلاقيات قرارات التصميم والسياسات المختلفة.

ويأمل (عوض) أن تساعد النتائج خبراءَ التقنية على التفكير بعمقٍ في أخلاقياتِ الذكاء الصنعي في السيارات ذاتية القيادة، وقال: لقد استخدمنا مسألةَ العربة لأنَّها طريقةٌ جيدة جدًّا لجمع تلك البيانات، لكننَّا نأمل ألَّا تبقى مناقشة الأخلاقيات ضمن هذا الموضوع، وأن تنتقل المناقشة إلى تحليلِ المخاطر -عمَّن هم أكثر عرضة للخطر ومن هم أقل ذلك- بدلًا من القول مَن سيموت ومن لا، وعن كيفيةِ حدوث التحيُّز أيضًا، وكيف يمكن ترجمة هذه النتائج إلى التصميم والتنظيم الأخلاقي للذكاء الصنعي.

يتابع عوض قائلًا: بدأ الناس في الثلاثة أعوام الأخيرة يتحدَّثون أكثر عن أخلاقياتِ الذكاء الصنعي؛ إذ أصبح المزيد من الناس يدركون أنَّ الذكاء الصنعي يمكن أن يكون له عواقبٌ أخلاقيةُ مختلفة على مجموعاتٍ مختلفة من الناس، ويعتقد برأيه أنَّ ذلك الأمرَ واعدٌ..

المصادر: